【機械学習とは 連載目次】

1. 人工知能・機械学習の黎明期

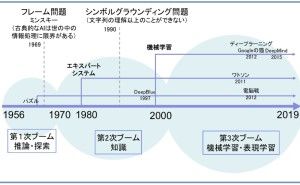

人工知能の歴史は意外と古く、戦後1950年代あたりにさかのぼれます。世界で最初のコンピュータENIACが誕生したのが1946年ですが 、その翌年にはチューリングが、はじめて人工知能の概念について述べています。それから、半世紀以上たった現在にいたるまで2回ほど大きなブームがありました。

最初は二分木に代表される、探索アプローチの時代でした。科学計算用の言語であるFORTRANが作られるとともに、探索に向いたLISPという言語も作られました。 また遺伝的アルゴリズムなども考案されましたが、探索的な発想では現実世界の問題に対処するには限界があるということが認識され、だんだん下火になってゆきました。

次に1970年以降から、知識表現についてさまざまなアイデアが出されるようになってきました。Prologなどの知識を扱うための言語なども作られ、エキスパートシステムという専門家の知識をコンピュータに乗せて適切に判断させるような仕組みの検討が行われる時代になりました。

このエキスパートシステムも専門家のレベルにするためには相当な判断情報が必要で、知識の構造とそのアクセス方法などでなかなかこれというものを見出せなかったと感じています。 ニューラルネットワークもこの時代には考えられましたが、数学的モデルの範疇(はんちゅう)にありました。今でこそ、数万円のパソコンでPythonを使いディープラーニングを動かすことができますが、当時は大型計算機でもどうかというレベルでしたから、理論先行も仕方がなかったのでしょう。

2. コンピューティング能力の向上

しばらくすると人工知能としての盛り上がりはなくなり、1990年代の中ごろからデータマイニングの技術が話題になってきました。データマイニングは多くのデータの中から、なんらかの傾向、法則性を発見する手法で当時マイニングツールもいろいろと出回るようになり、これはやがてDWH(データウェアハウス)とかBI(ビジネスインテリジェント)ツールなどになってゆき、各社が盛んにソリューション提案を行うようになりました。

現在は3回目のブームといわれていますが、その一番大きな要因は、主に2000年代以降に生じたコンピュータ性能のコストパフォーマンス向上にありました。それまでは理論ベースだったニューラルネットワークを、実時間で計算できるようになったわけです。機械学習という言葉が使われるようになったのは、このあたりからですが、比較的低コスト、短時間で計算できるようになると、アルゴリズムの改良が急速に進むことになったわけです。

3. 人工知能のレベル

人工知能研究者らの間ではよく知られたことですが、人工知能には難問として知られる「フレーム問題」、「シンボルグラウンディング問題」というのがあります。これらは簡単にいうと、コンピュータは人間と同じような思考ができない、もっというと「概念」を持てないということをいっているわけです。

では、今はどの程度なのかといいますと、概念は持てないが「素性設計(Feature Engineering)」の課題...

これ以降、ディープラーニングの階層モデルは急速に研究が進み、RNN、LSTMなどのような過去情報を記憶するモデル、GANsのような識別能力を鍛えるモデル、Q値計算にDNNを活用した強化学習であるDeep Q-learningなどが次々と考案されてきています。

次回は、機械学習手法について、解説します。