▼さらに深く学ぶなら!

「データ分析」に関するセミナーはこちら!

▼さらに幅広く学ぶなら!

「分野別のカリキュラム」に関するオンデマンドセミナーはこちら!

近年、機械学習の技術はビジネスのあらゆる分野で急速に進化し、企業の意思決定プロセスに革命をもたらしています。しかし、複雑化するモデルの背後にある「なぜ」という問いに答えることは、ますます困難になってきています。今回は、解釈可能な機械学習モデルと事後的解釈手法の両方に焦点を当て、実際のビジネスシーンでの応用事例を通じて、これらの手法がどのように企業の意思決定を支援し、ビジネス価値を高めることができるかを説明します。医療、金融、小売といった多様な業界における事例を紹介し、機械学習モデルの透明性と効果性を最大化するための戦略の重要性を感じて頂ければと思います。今回は、連載3回のその1です。

【記事要約】

解釈可能な機械学習モデルと事後的解釈手法がビジネスにおいていかに重要であるかを、幾つかの事例を通じて説明しました。これらの先進的な手法がどのように実用的なデータインサイトを提供し、企業の意思決定プロセスを支援したのか、何となく理解できたのではないかと思います。解釈可能な機械学習モデルは、予測の背後にある論理を明確にし、解釈不可能な機械学習モデルに対しては事後的解釈手法により、より複雑なモデルの意思決定プロセスを理解するための鍵を提供することがえきます。このようにして、ビジネスはデータ駆動型の意思決定を行い、より効果的な戦略を策定し、競争上の優位性を確保することができます。今後も、機械学習モデルの進化とともに、その解釈と応用の方法はさらに重要性を増していくでしょう。

◆ なぜ「解釈可能ML(機械学習)」が必要なのか? 主な手法と事例のご紹介(連載3回のその1)

1. 機械学習モデルの解釈性の重要性

(1)機械学習モデルの出力を理解することの価値

機械学習モデルは、データから複雑なパターンを学習し、予測や決定を行います。しかし、モデルがどのようにこれらの結果に至ったかを理解することは、単に技術的な挑戦以上の意味を持ちます。モデルの出力を解釈する能力は、信頼性、透明性、そして責任ある利用を確保する上で不可欠です。特に、高リスクや規制された業界(例えば医療、金融)では、決定の背後にある理由を正確に理解し、説明することが法的要件にもなり得ます。

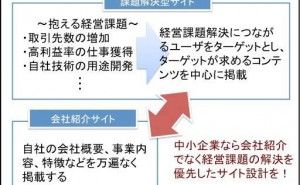

(2)機械学習が組み込まれた製品やサービスの購入・利用の決定要因

ビジネスの文脈では、機械学習モデルは製品やサービスの一部として組み込まれます(例:AI搭載〇〇サービス)。製品やサービスの見込み顧客や利害関係者にモデルの振る舞いを理解してもらうことは、機械学習モデルの組み込まれた製品やサービスの信頼性と受容性を高める上で重要です。また、モデルの透明性は、潜在的なバイアスや不公平な扱いを特定し、是正する上でも重要です。

2. 機械学習モデルを解釈する技術の概要

(1)解釈可能性とは?

解釈可能性とは、機械学習モデルの予測や決定がどのように行われたかを人間が理解しやすい形で説明できる程度を指します。機械学習モデル、特に複雑なモデル(例えば、深層ニューラルネットワーク)は、高い予測精度を持ちますが、その決定プロセスが複雑で、なぜ特定の予測や決定がなされたのかを理解するのが難しい場合があります。

【解釈可能性の重要性】

- 信頼性の向上: モデルの動作が理解できると、ユーザはモデルの予測をより信頼することができます。

- エラーの特定: モデルの予測に問題がある場合、その原因を特定しやすくなります。

- フィードバックと改善: 解釈可能なモデルは、フィードバックを受け入れ、改善するのが容易です。

- 規制とコンプライアンス: 特に金融や医療などの規制が厳しい分野では、モデルの決定を説明することが法的要件になっている場合があります。

- 倫理的透明性: 特に個人情報を扱う場合、モデルの決定プロセスが透明であることは、倫理的な問題やバイアスのリスクを減少させるのに役立ちます。

すべての機械学習モデルが解釈性が高いわけではありません。機械学習モデルには、解釈可能な機械学習モデルと解釈不可能な機械学習モデルに分かれます。解釈不可能な機械学習モデルに対しては事後的解釈手法を用います。