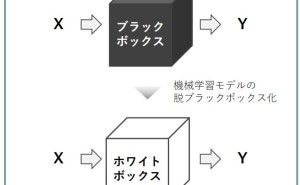

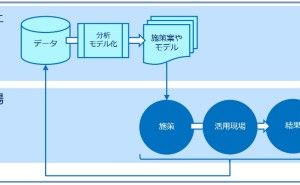

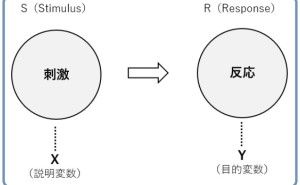

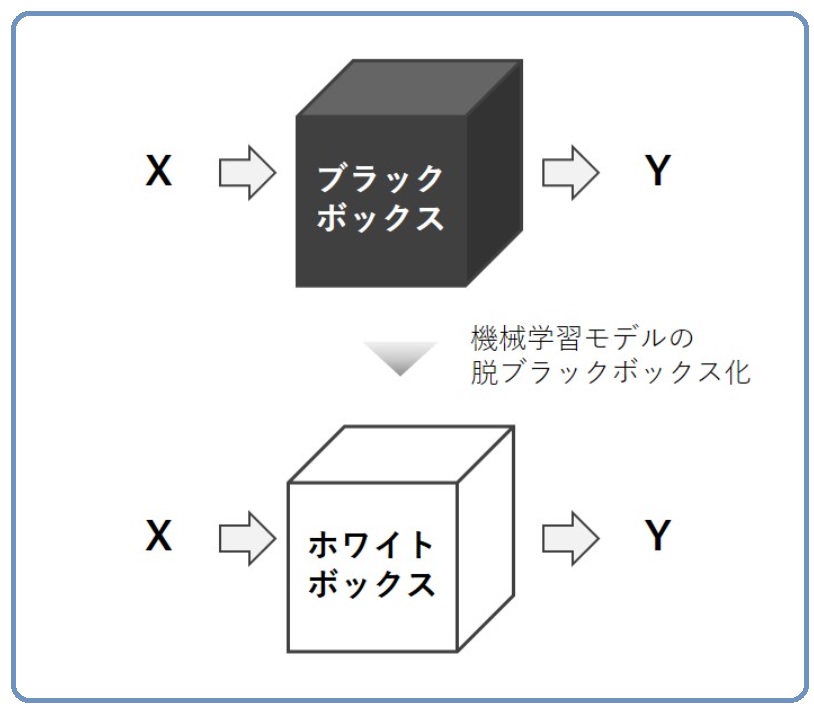

機械学習で構築した数理モデルが、ブラックボックス化するケースは少なくありません。そのような中、最近よく聞くキーワードに「XAI」というものがあります。XAIとは「Explainable Artificial Intelligence」の略で、日本語では説明可能AIと表現されることが多いです。ちなみに、「説明可能AI」とは「AIが何かを説明してくれる」というわけではありません。

「説明可能AI」とは、予測に至るプロセスが説明可能になっている「機械学習で構築した数理モデル」のことです。そもそもAIとは何か? といい議論がありますが…… XAIのAIとは、数理モデルのことを言っています。今回は、「最近注目を浴びてきた説明可能AI(XAI、Explainable Artificial Intelligence)、ブラックボックスのホワイトボックス化」というお話しをします。

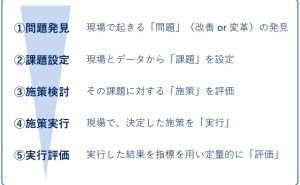

【目次】

1.DARPA XAI プロジェクト

2.ブラックボックスのホワイトボックス化

3.「説明可能AI」(XAI)の3つのアプローチ

(1)Deep Explanation

(2)Interpretable Models

(3)Model Induction

4.入門的なテキスト

1.ARPA XAI プロジェクト

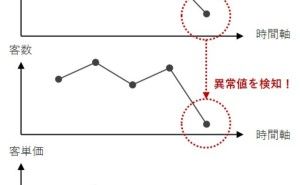

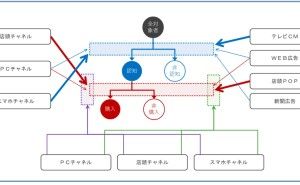

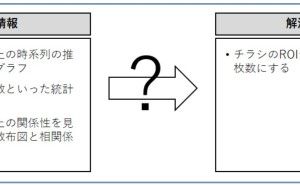

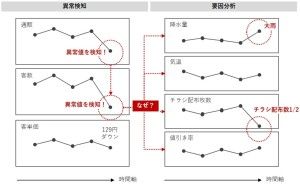

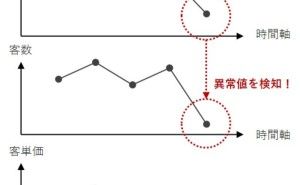

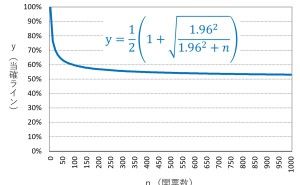

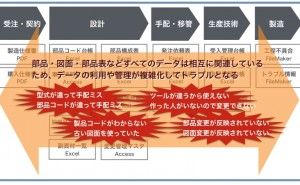

ある米国の組織が「説明可能AI」(XAI)というワードを使い始めました。国防高等研究計画局DARPA(Defense Advanced Research Projects Agency)です。機械学習で構築する数理モデルは、精度を求めるとブラックボックスになりやすくなります。

ブラックボックスになるということは、解釈し難くなり説明し難くなるということです。しかし、使う側にとってはそれでは困ります。得体の知れないものを使うには、勇気がいります。「説明可能AI」(XAI)の本質は、納得感の提供と、人と機械のコラボレーションなのでしょう。

2.ブラックボックスのホワイトボックス化

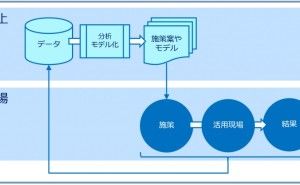

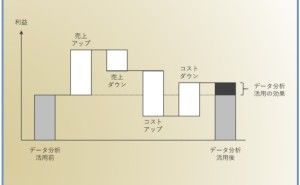

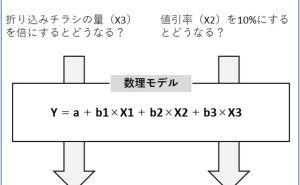

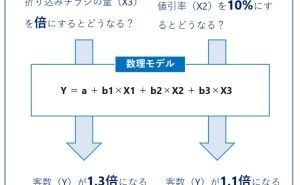

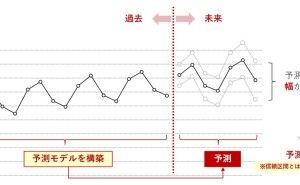

繰り返しになりますが、数理モデルは予測精度を追及するとブラックボックスになり解釈性が低くなる傾向あります。使う側にとって、意味不明なものを使うは気持ちの悪いものです。そのような中、社会的な要請として「説明責任」がAIサービス提供側に求められてきています。

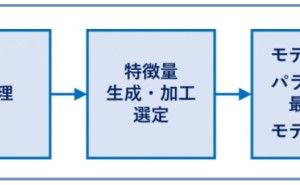

そもそも、数理モデルを構築するデータ分析者やデータサイエンティスト、機械学習エンジニアにとって、数理モデルを改良するときに解釈しやすいほうが何かと便利です。

3.「説明可能AI」(XAI)の3つのアプローチ

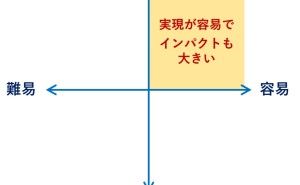

「説明可能AI」(XAI)には、現在3つのアプローチがあります。※各アプローチ名の日本語訳は知りません。

- Deep Explanation

- Interpretable Models

- Model Induction

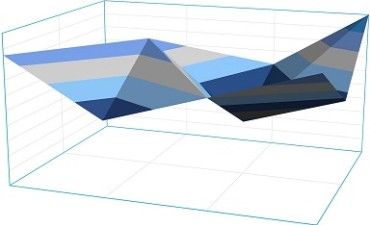

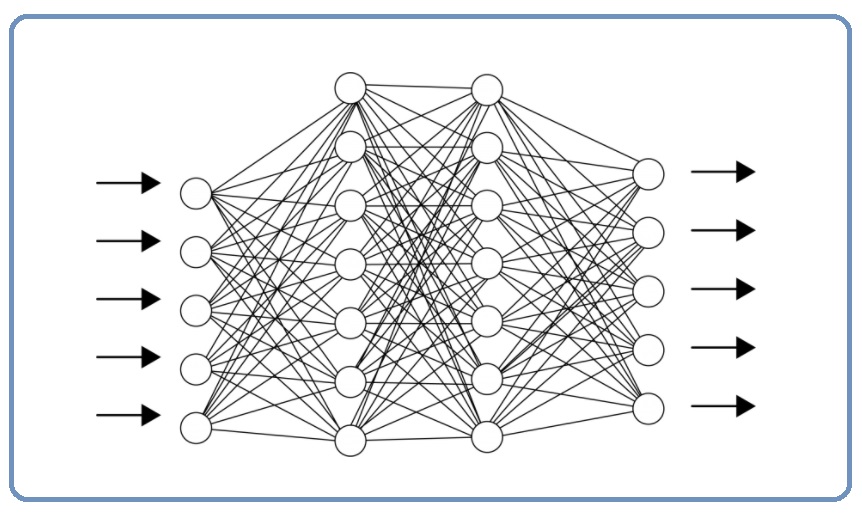

(1)Deep Explanation

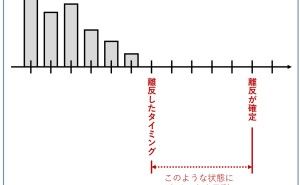

どちらかと言うと、ニューラルネットワーク型のディープラーニングで構築した数理モデルに対し行われるケースが多いです。例えば、特徴マップというものを作った後に、アテンションヒートマップというヒートマップグラフを作成し、視覚的に理解を助けるものです。手法としては、勾配ベースのハイライト法が有名で、色々なアルゴリズムが発案されています。

ちなみに、このヒートマップを専門外の人が眺めても、訳は分かりません。専門家向けのものです。専門家とは、その分野(機械学習というよりその活用領域)の専門家です。ヒートマップを見て、ピンとくる程度の専門家です。

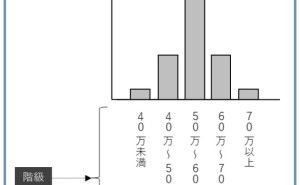

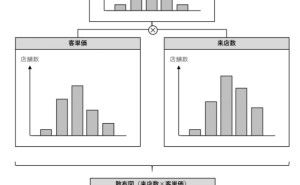

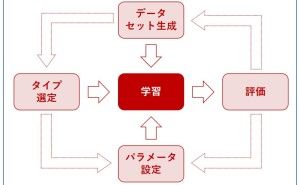

(2)Interpretable Models

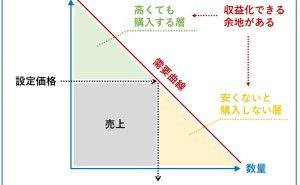

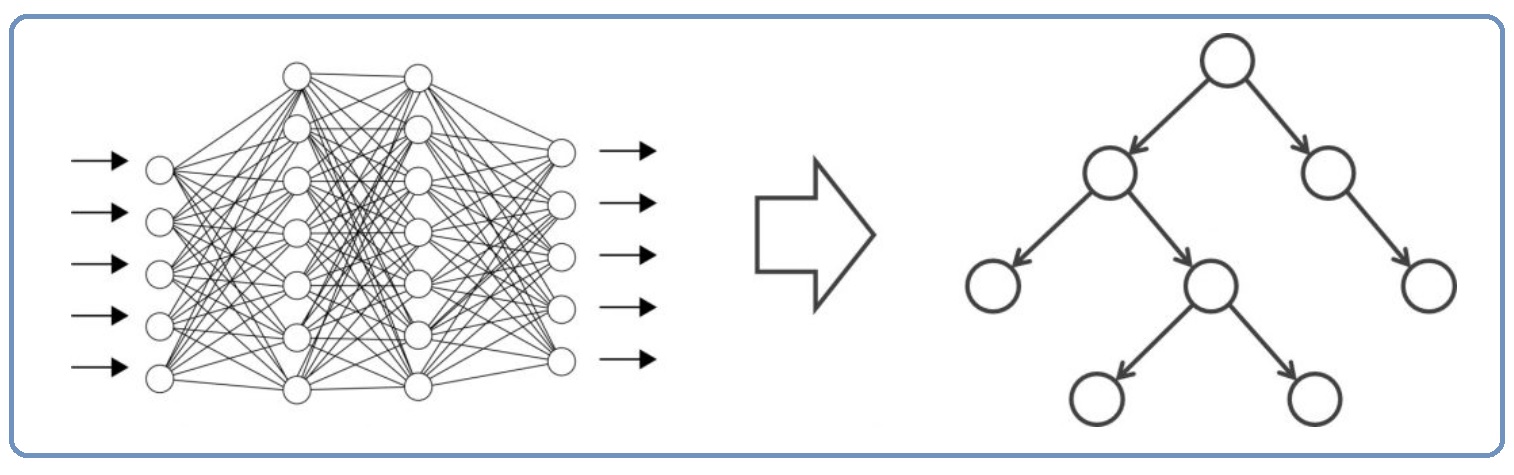

ブラックボックス化しやすい数理モデルではなく、ホワイトボックス型の数理モデルで頑張る! というものです。

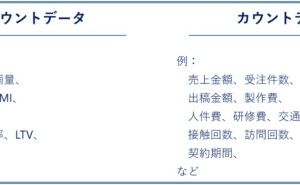

ホワイトボックス型の数理モデルとは、例えば……

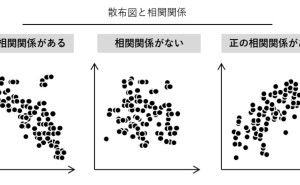

- 線形回帰系の数理モデル(単回帰、重回帰、ロジスティック回帰など)

- 決定木

- ランダムフォレスト

……などです。

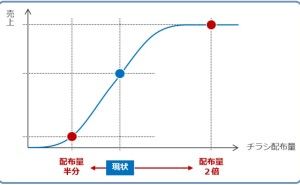

例えば、ブラックボックス型の数理モデルの精度と比べ、それほど悪くないホワイトボックス型の数理モデルを構築できるのならば、そのほうがいいよね! という感じです。手法としては、複雑な数理モデルを決定木で近似するBATreesが比較的有名です。ランダムフォレストで近似するdefragTreesというのもあります。

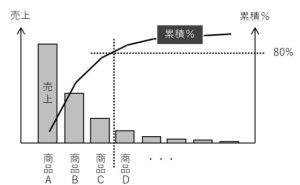

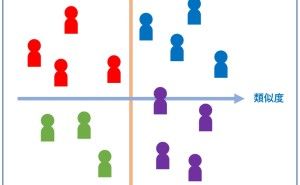

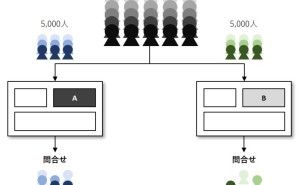

(3)Model Induction

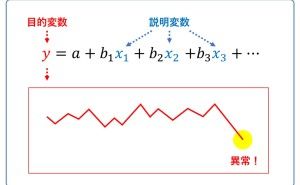

主に、説明モデル(explanatory model)の数理モデルを使って説明する方法です。

説明モデル(explanatory model)という概念自体は、昔からあり医学系でよく目にします。「説明可能AI」(XAI)では、「Additive Feature Attribution Methods」と呼ばれる数理モデル化した説明モデル(explanatory model)を使うケースが多いです。

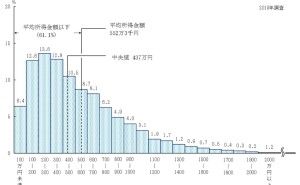

例えば、心理学や経済学で登場するゲーム理論のシャープレー値(Shapley values)を応用したものなどが有名で...